Placas de vídeo — a evolução das GPUs na década

GPU Wars — veja um pequeno histórico das placas de vídeo lançadas entre 2010 e 2019. Será que tal componente vital no hardware para games evoluiu muito?

Emanuel Laguna 4 anos atrás

Nos últimos 10 anos, os processadores centrais para desktop pouco evoluíram: no máximo incrementaram o nível de desempenho bruto e número de núcleos (físicos e lógicos). Tal estagnação tecnológica tem como culpado um mercado amplamente liderado pela Integrated Electronics. E quanto aos processadores gráficos? Será que as placas de vídeo evoluíram muito ao longo desses dez anos?

- Os processadores gráficos e suas placas de vídeo

- Microsoft possui um belo museu particular de placas de vídeo

DG1 — a Intel pretende lançar sua “primeira” GPU dedicada no mercado em 2020 (crédito: Tom’s Hardware)

Apesar de o tio Laguna considerar a atual segunda década do século começando por 2011, os algoritmos de busca adoram a ideia de começar pelo zero. Estabelecido o período analisado, comecemos então pelas GPUs lançadas em 2010.

GPUs em 2010

Em março daquele ano, a nVidia lançou as placas de vídeo com GPU GeForce GTX 480. Em reação direta e imediata a tal lançamento da camaleão verde de Santa Clara, a então concorrente ATi lançou no mercado a edição Eyefinity da Radeon HD 5870, GPU lançada seis meses antes.

Ao final de 2010, por volta de outubro, a agora AMD lançou a Radeon HD 6870. Uma Radeon HD 6970 seria lançada no Natal de 2010. Enquanto isso, a nVidia não ficou parada: em novembro de 2010 ela lançou a GeForce GTX 580.

| Especificações das GPUs high-end de 2010 | ||||

| GPU → | Radeon HD 5870 (Eyefinity) |

GeForce GTX 480 | GeForce GTX 580 | Radeon HD 6970 |

| arquitetura | TeraScale 2 | Fermi (GF100) |

Fermi (GF110) |

TeraScale 3 |

| litografia | 40 nm | 40 nm | 40 nm | |

| configuração | 32 ROPs / 80 TMUs |

48 ROPs / 60 TMUs |

48 ROPs / 64 TMUs |

32 ROPs / 96 TMUs |

| núcleos | 1.600 | 480 | 512 | 1.536 |

| clock máximo | 850 MHz | 1,4 GHz | 1,54 GHz | 880 MHz |

| desempenho bruto (precisão simples) |

2,7 Tflop/s | 1,35 Tflop/s | 1,58 Tflop/s | 2,7 Tflop/s |

| VRAM | 2 GB GDDR5 | 1,5 GB GDDR5 | 2 GB GDDR5 | |

| clock da memória | 1,2 MT/s | 0,9 MT/s | 1 MT/s | 1,38 MT/s |

| interface da memória | 256 bits | 384 bits | 256 bits | |

| TDP | 230 W | 250 W | 245 W | 250 W |

| lançamento original | 11/03/2010 | 26/03/2010 | 09/11/2010 | 15/12/2010 |

| preço de lançamento na civilização | US$ 479 (≈ US$ 561 hoje) |

US$ 499 (≈ US$ 585 hoje) |

US$ 369 (≈ US$ 432 hoje) |

|

·

Sim, o ano final da primeira década do século XXI viu no mínimo dois novos lançamentos semestrais de GPUs que equipariam, no mundo civilizado, placas de vídeo entre US$ 369 e US$ 499 (US$ 432 a US$ 585 em valores atuais). Isso tudo para jogar lançamentos para PC como Assassin’s Creed 2, Battlefield: Bad Company 2, Darksiders, Mass Effect 2, STALKER: Call of Pripyat e Supreme Commander 2.

Para quem estivesse disposto a gastar US$ 699 (819 dólares hoje), em 2010 levaria para casa enormes placas de vídeo com duas GPUs high-end em SLi/CrossFire bem integradas (no caso chamadas de GeForce GTX 590 ou Radeon HD 5970). Sem falar na confusão de placas de entrada e intermediárias disponíveis naquele ano, pois embora todas as quatro GPUs topo de linha citadas na tabela sejam de segunda/terceira geração DirectX 11, muitas lojas brasileiras ofereciam low e mid DX10 ainda.

Ao final do ano seguinte, 2011, adquiri uma Sapphire Radeon HD 6850 que sobreviveu no meu desktop até o início do presente ano: foram 7,5 anos de uso. Com 1,4 teraflop/s (algo equivalente aos 900 gigaflop/s numa Radeon GCN posterior) hoje ela provavelmente nem chega a ser patamar mínimo de desempenho gráfico na maioria dos lançamentos para PCs. Para não alongar muito, vamos pular para o próximo evento mais relevante em GPUs, ocorrido no final de 2013.

GCN 2: o início da 8ª geração de consoles

Como todo mundo já cansou de saber, Sony e Microsoft escolheram AMD como fornecedora dos processadores central e gráfico do PlayStation 4 e Xbox One. Ambos os consoles possuem basicamente a mesma CPU octa-core, mas diferem um pouco na GPU: a do PS4 seria a versão completa com 18 unidades GCN 2, enquanto a do Xbox One só possui 12 embora com clock mais elevado.

Radeon R9 290 contra GeForce GTX 780 Ti (crédito: LinusTechTips)

Embora a GPU do PS4 tenha desempenho bruto que equivaleria ao dobro da minha finada Radeon HD 6850, mesmo em 2013 já poderíamos comprar na civilização GPUs desktop que superavam tais consoles, até porque começou ali o uso de placas de vídeo como mineradoras de criptomoedas. E o lançamento da API AMD Mantle, substituída pela Vulkan em 2019.

Peguemos como exemplo uma Radeon R9 290, lançada dia 5 de novembro de 2013 por US$ 399 (437 dólares atuais). Ela é da arquitetura GCN 2, litografada no mesmo processo de 28 nm da APU dos consoles, e consegue atingir um desempenho bruto de 4,8 teraflop/s. Isso é quase o quádruplo da GPU do Xbox One.

Por volta da mesma época, estava disponível no mercado a versão Ti da GeForce GTX 780: custava 699 dólares (US$ 767 atuais) e apesar de performar “apenas” 5 teraflop/s, a arquitetura Kepler conseguia superar a GCN 2 na grande maioria dos testes contra GPUs concorrentes. Com os drivers e softwares otimizados daquela época. Seria interessante revisitar tais testes e ver qual placa teria sido mais resistente ao futuro.

GPUs em 2016

Muitas das melhorias no hardware das GPUs tiveram como base o incremento do número dos núcleos de processamento gráfico, aliado ao aumento dos clocks de operação e processos de litografia onde os transistores ficam cada vez menores. Dito tudo isso, Sony e Microsoft tiveram a ideia de anunciar ou mesmo lançar de facto versões melhoradas de seus consoles naquele ano, ao fazerem a transição da litografia das respectivas APUs de 28 para os 16 nm.

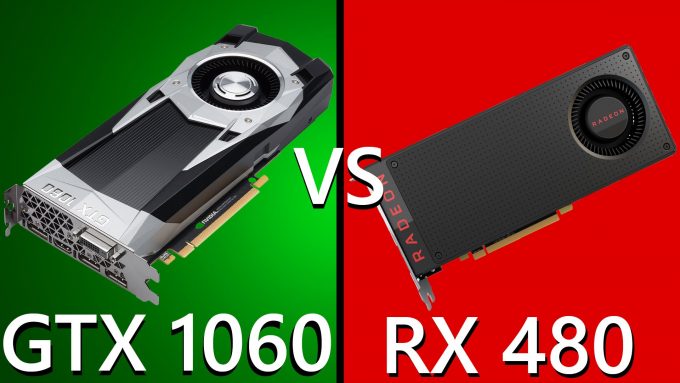

O processo FinFET da TSMC de 16 nanômetros e o de 14 nm da Samsung e GlobalFoundries, foram as litografias contemporâneas das GPUs desktop também naquele ano. Enquanto a primeira foi usada pela nVidia na GPU topo de linha GeForce GTX 1080, a segunda foi utilizada pela AMD na GPU intermediária Radeon RX 480. Tais GPUs desktop foram as primeiras 100% compatíveis com o DirectX 12, API lançada em 2015.

As intermediárias mais populares de 2016 (crédito: TechFrag)

A Radeon RX 480 foi a primeira representante comercial da arquitetura GCN 4, esta presente no PS4 Pro e Xbox One X. No ano seguinte, a AMD lançaria uma versão melhor, mais rápida e mais estável da RX 480, a Radeon RX 580.

Foi em 2016 que também recomeçou o boom das criptomoedas: com o bitcoin ultrapassando os 1.000 dólares ao final daquele ano, em 2017 veríamos os preços das placas de vídeo dispararem mais uma vez nas lojas da civilização.

Em 2017 muita gente montou PC com várias placas em CrossFire/SLi para minerar criptomoedas 24 horas por dia. Um senhor estresse para tais GPUs e que levou a AMD e nVidia a desenvolverem e lançarem placas de vídeo específicas para tal fim, algumas sem saída de vídeo.

As GPUs mais atuais e tendências para o futuro

Ano passado a nVidia lançou a família RTX 20, capitaneada pelos 13 Tflop/s da GeForce RTX 2080. Neste ano a camaleão verde lançou uma versão melhorada delas, a série GeForce RTX 20 Super. Tais GPUs Turing litografadas em 12 nm incluem o suporte completo ao DXR — DirectX Raytracing, extensão compatível do DX12, e núcleos Tensor dedicados para inteligência artificial.

Enquanto isso, o Radeon Technologies Group lançou no início de 2019 a Radeon VII, uma GPU Vega GCN 5 litografada em 7 nm com desempenho bruto de 14 teraflop/s mas que não possui unidades de processamento específicas para raytracing e inteligência artificial no hardware. A vitrine do RTG em 2019 foi o lançamento das GPUs Navi RX 5000, capitaneada pela Radeon RX 5700 XT (10 Tflop/s). Ela é baseada na arquitetura RDNA 1, possuindo suporte nativo ao DXR.

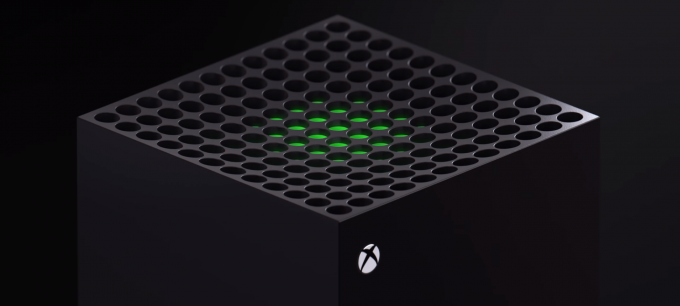

O topo do novo Xbox, disponível em 2020

Como a nVidia domina o mercado de GPUs desktop, as vitrines mais populares para o trabalho do RTG serão o PS5 e o Xbox Series X. Este promete ter uma GPU RDNA 1 ou 2 com 12 teraflop/s de desempenho bruto e, além do DXR no hardware, terá suporte a 8K ou 120 fps. Uma promessa e tanto!

Concluindo, podemos ver que em dez anos o desempenho bruto das GPUs cresceu sete vezes e o tamanho dos transistores diminuiu para entre um quarto e um quinto do que eram lá em 2010. Entretanto, para o tio Laguna a verdadeira evolução das GPUs nesses 10 últimos anos foi no software: não adianta uma GPU mais antiga ter, sei lá, os mesmos 13 ou 14 teraflop/s das topo de linha atuais e ela “desperdiçar” desempenho bruto com instruções mais atuais, que nas novas GPUs levam menos ciclos.