GeForce GTX 580: nVidia corre atrás das Radeon HD 6000 com o verdadeiro Fermi?

Vista seu terno Armani e use seus óculos Dolce & Gabbana para contemplar o glamouroso desfile Graphics Fashion 12 da nVidia, com a participação especial da Top Model internacional, a GeForce GTX 580.

Emanuel Laguna 13 anos atrás

Imaginemos a seguinte situação: acabamos de fazer aquele generoso investimento por uma nova placa de vídeo no computador desktop.

Ela ficará escondida dentro daquele gabinete metálico, sendo notada apenas quando saciamos o desejo pelos melhores e mais fluidos gráficos tridimensionais que a nova peça permitirá, nos raros novos jogos para PCs.

Como ostentar tal luxo?

Como alimentaremos uma possível admiração alheia por esse investimento sofisticado que, fisicamente, parece ser tão discreto?

Bom, alguns modificam bastante o gabinete a fim de exibir todo o interior do desktop, ao colocar mais furos e janelas: o porém é que tal reforma só parece chamar a atenção dos micreiros e outros entusiastas por casemod.

Mas há uma outra alternativa mais esperta, mais elegante, mais fashion e alinhada com as “tendências da estação”: se a moda é o 3D estereoscópico, por que não entrar nela com muito estilo?

No próximo mês, dezembro (aka final da primavera), a chiquérrima grife italiana Gucci colocará no mercado estilosos óculos compatíveis com o 3D Vision Surround.

Isso mesmo, nada de baratos óculos futuristas vindos de filmes como Tron Legacy: o modelito de módicos US$ 225, dos óculos 3D unissex da Gucci, remete ao estilo retrô dos anos 80 e a armação tem basicamente o mesmo desenho que a diretora criativa Frida Giannini trouxe para a coleção Eyeweb Gucci, no inverno do ano passado.

Todo esse luxo combina com o glamouroso desfile Graphics Fashion 12, dos novos processadores gráficos DirectX 11 da nVidia. E a primeira GPU na tal passarela é ninguém menos que a badalada Top Model GeForce GTX 580:

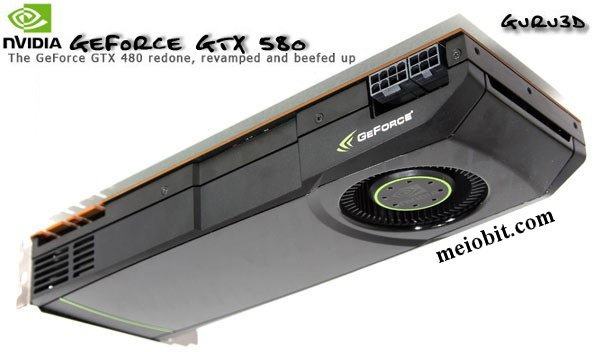

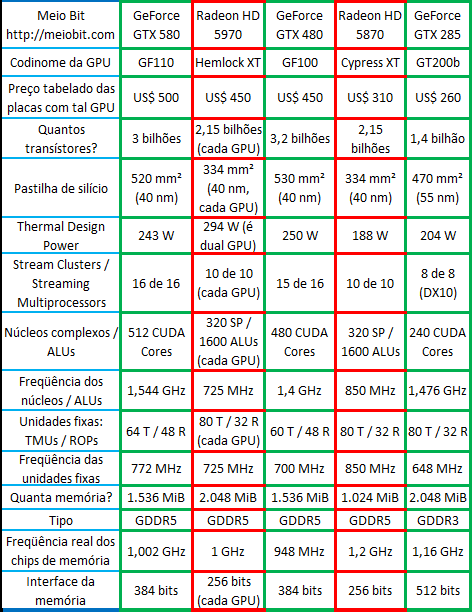

A bela modelo GF110, da camaleão verde de Santa Clara, desfilou em Portland seus 3 bilhões de transístores litografados a 40 nm.

Isso nos dá uma pastilha de silício com 520 mm² de área (10 mm² menor que o GF100).

Só que a GF110 ainda é um chip tão grande que a respectiva placa de vídeo possui um generoso consumo elétrico máximo de 280 watts-hora (coisa chique mesmo é poder esbanjar na conta de luz, é ou não é?): a die propriamente dita necessita de um TDP por volta dos 243 watts para mantê-la arrefecida a 80 ºC!

São números que impressionam, embora a estilista da primeira GeForce 12 se trate de uma velha conhecida nossa: a microarquitetura Gráficos Fermi.

A famosa costureira taiwanesa, a TSMC, parece ter conseguido melhorar o yield em comparação com a situação inicial da GeForce 11: sim, a nVidia demorou mais seis meses para finalmente por no mercado o Fermi original, completinho (16 SMs inalterados) e “otimizado” a 772 MHz (72 MHz a mais que a GeForce GTX 480).

O que haveria de tão diferente na GeForce GTX 580?

A única otimização real que o tio Laguna notou, na microarquitetura do velho novo processador gráfico GF110, foi a capacidade de todas as 64 unidades texturizadoras também trabalharem com as velhas texturas em precisão parcial (FP16) num único “ciclo de clock”: algo que só me parece realmente útil para o filtro anisotrópico nos jogos DX9c e em outras aplicações com limitado nível de texturização.

Em quase todas as GPUs DX10, DX10.1 e DX11 lançadas até então (exceto pelas GF104, GF106 e GF108), somente metade das TMUs também trabalham com a precisão parcial e a outra metade era especializada na texturização dos polígonos com precisão “completa” (FP32) ou dupla (FP64).

Ao somarmos também a maior freqüência na memória (1,002 GHz ante os 948 MHz da GTX 480) no panorama, a nVidia alega que a GeForce GTX 580 conseguiria 14 % a mais de desempenho geral que a antecessora. Para não dizerem por aí que o tio Laguna é fã cego da concorrente, ele confiará na nVidia, até porque os testes a seguir não desmentem a camaleão verde (para o desespero de meu lado rubro):

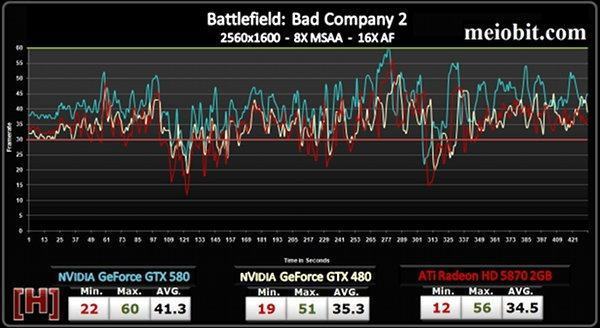

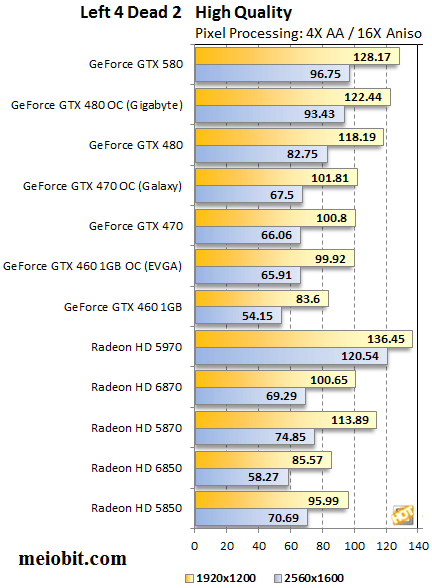

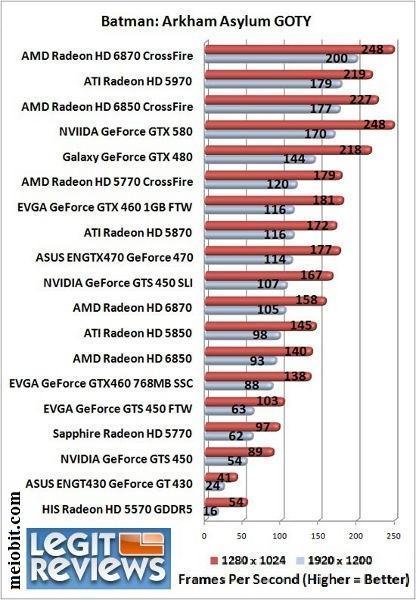

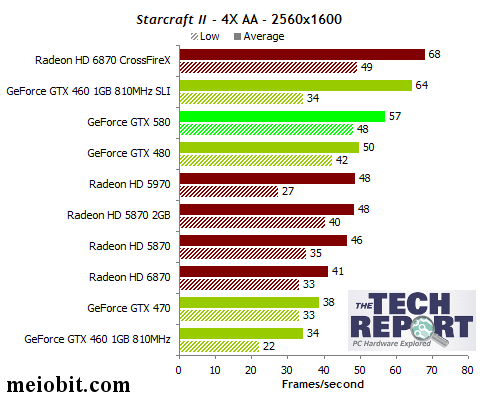

Podemos ver num dos dois testes acima, na resolução 2560x1600, que a GeForce GTX 580 cumpre com o prometido. Simples assim: a estreante da família GeForce 12 consegue ser o mais rápido processador gráfico DX11 da atualidade e deixa a dual-GPU Radeon HD 5970 em apuros. Os dois testes abaixo possuem comportamento semelhante:

O tio Laguna ficou bastante surpreso em ver a versão 2 GiB das placas de vídeo com a Radeon HD 5870 encostar na estreante GF110: será que a AMD+ATi economizou demais na quantidade de memória e tal contenção de custos representou um gargalo em resoluções maiores?

Suspeito que sim: ao que tudo indica, os próximos lançamentos da AMD incluirão 2 GiB por GPU nas respectivas placas de vídeo.

Isso quer dizer que veremos as high-end Radeon HD 6970 e 6950 com 2 GiB de memória de vídeo logo de cara e, possivelmente, a dual-GPU Radeon HD 6990 virá em longas placas de vídeo com 4 gigabytes: nem preciso dizer que tal quantidade de memória só será bem aproveitada nos sistemas operativos de 64 bits!

AMD HD3D: o concorrente do 3D Vision Surround

Aliás, não é somente com uma quantidade de memória maior que a AMD terá de se preocupar nos próximos lançamentos da série Radeon HD 6000: embora a série anterior (Radeon HD 5000) possua alguma capacidade de exibir imagens em 3D estereoscópico através do Eyefinity, foi na série 6000 que a AMD estabeleceu o seu recurso padrão para imagens estereoscópicas, o AMD HD3D.

Enquanto a nVidia desenvolve suas GPUs para oferecerem o 3D Vision Surround em televisores HDTV 3D Ready pela conexão HDMI ou então para os monitores com a rara conexão DVI Dual-Link, a AMD prefere adicionar o AMD HD3D através da larga conectividade proposta pelo DisplayPort, um padrão aberto de conexões digitais por onde passam áudio e vídeo.

Ambas as soluções parecem gerenciar bem uma única tela, mas eu tenho minhas dúvidas em relação a fazer o mesmo tão bem em diversas telas associadas (para formar uma única imagem em maior definição): cada tela adicional demanda mais processamento gráfico, justamente para manter os 120 fotogramas por segundo necessários para que cada olho do observador receba uma perspectiva tridimensional a 60 fps.

Para enxergar tais imagens estereoscópicas, normalmente a fabricante do televisor e/ou monitor sugere determinados óculos só compatíveis com este ou aquele modelo. Tanto a nVidia quanto a AMD dão essa liberdade, embora ambas se associem à tradicionais fabricantes de óculos, como a Gucci e a Oakley, para que haja alguma melhor otimização no uso desse cobiçado recurso visual em diferentes telas, de diversas faixas de preços.

A terceira versão da GeForce GTX 460

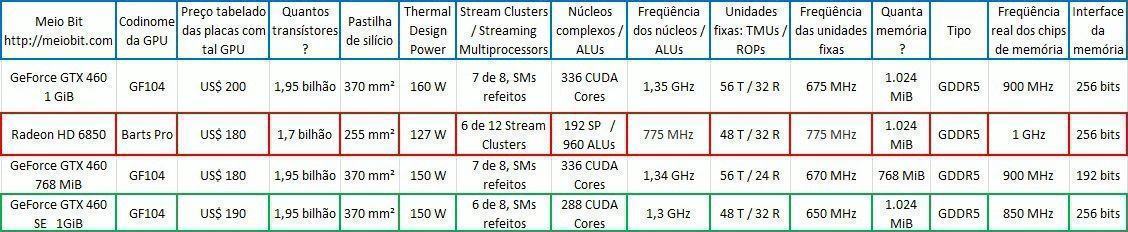

Por falar em maior diversidade de preços, a nVidia fez um outro lançamento, bem silencioso e paralelo à GeForce GTX 580: uma versão intermediária da GeForce GTX 460, a Special Edition.

Em comparação com a versão mais completa, a Special Edition da GeForce GTX 460 perde um SM mas mantém todas as unidades rasterizadoras e a interface de memória de 256 bits, sem contar os 256 MiB de memória GDDR5 a mais que a placa de vídeo com a outra versão da GF104.

Outro lançamento silencioso da nVidia poderia ser uma GeForce GTX 570, mas ainda é um tanto cercada por rumores: dizem que ela substituiria a atual GeForce GTX 480, ao ser constituída por 15 SMs da GF110.

É, este final de ano promete… 😮