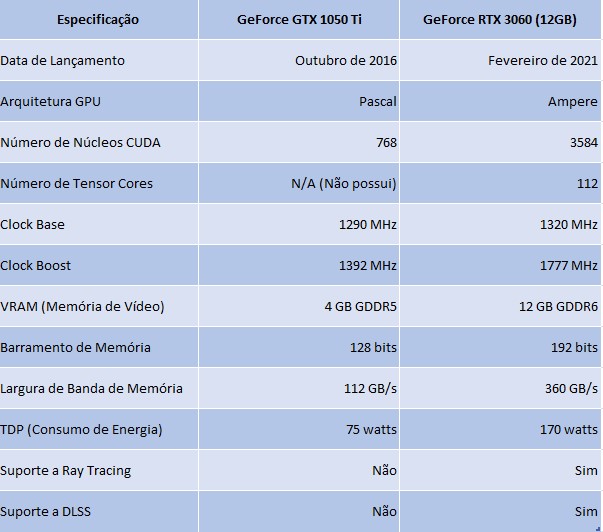

Resenha: GeForce RTX 3060/12 GB – Ideal para IA

A GeForce 3060 foi testada e aprovada, é a melhor placa para quem quer usar aplicações de IA rodando localmente. Acompanhe como chegamos lá

Carlos Cardoso 24 semanas atrás

A GeForce RTX 3060 não é a mais nova nem a mais poderosa GPU da Nvidia, mas é universalmente considerada a melhor opção “pé no chão” para quem quer desenvolver aplicações envolvendo Inteligência Artificial. Vamos entender o porquê.

GeForce RTX 3060/12 GB (Crédito: Nvidia)

Por que GPUs?

Muito tempo atrás, no longínquo ano de 2006, a Nvidia lançou suas GPUs com arquitetura Tesla, a grande novidade é que pela primeira vez uma API dava acesso às chamadas “Unidades de Processamento de Fluxo”, que mais tarde seriam conhecidos como Núcleos CUDA, da sigla em inglês para "Arquitetura Unificada de Dispositivos para Computação".

As tais unidades de processamento eram núcleos computacionais rodando em paralelo, otimizados para operações algorítmicas repetitivas, como por exemplo uma simulação de partículas gerando efeitos de água, com distorção e reflexos. Calcular linearmente é muito demorado e custoso, com CUDA você pode dividir a cena entre vários núcleos e cada um calcula um pedaço, ao mesmo tempo.

Esta pessoa - e a movimentação - não existem, tudo foi calculado do zero.

A grande jogada visionária da Nvidia foi tornar a API flexível, permitindo que programas externos executassem operações matemáticas nos núcleos CUDA que não são necessariamente relacionados com gráficos e efeitos visuais.

Com o tempo foram introduzidos mais recursos nos núcleos CUDA, de Transformação Rápida de Fourier a uma biblioteca analítica de Grafos. Coisa fina.

A capacidade de processamento também cresceu de forma avassaladora. A GeForce 8800 GS tinha 96 núcleos CUDA. Hoje a GPU mais poderosa da Nvidia, a RTX 4090 vem com 16384 núcleos.

GeForce 8800 Ultra. Com duas saídas DVI e uma SVHS! (Crédito: Hyins / Wikimedia Commons)

As aplicações de Inteligência Artificial, baseadas em Álgebra Linear fazem uso extensivo de cálculos de matrizes com milhares de dimensões, o conceito de redes neurais envolve milhões, às vezes bilhões de parâmetros. O Stable Diffusion trabalha com 890 milhões, o GPT 3.5, com 175 bilhões de parâmetros. Executar isso de forma linear em uma CPU, mesmo com um Threadripper 3990X, com 128 threads, levaria uma eternidade.

Isso foi logo percebido pelo meio acadêmico, e a Nvidia lançou suas GPUs voltadas para o mercado científico e profissional, culminando hoje na A100 com 80 GB de VRAM, um monstro que só é superado pelo HGX A100, um monstro que combina até 16 A100s, e custa todo o dinheiro do mundo.

Entra o Crypto

GPU sempre foi um negócio caro, minha estratégia costumava ser ficar duas ou três gerações atrás da geração atual, como meu consumo de games é normal, sem as taradices de overclocar a máquina para ganhar 2fps, ficar para trás funcionava, mas eis que veio a moda das criptomoedas, com todo mundo gastando milhões em eletricidade em cálculos inúteis, para gerar números arbitrários e ficar rico.

Isso gerou uma demanda por GPUs que pegou todo mundo de surpresa, os preços foram para a estratosfera, os fabricantes não conseguiam entregar placas rápido o suficiente. Isso foi horrível para os gamers e para os cientistas de dados.

Para nossa sorte, a dificuldade em minerar criptomoedas cresce exponencialmente, e a maioria dos especuladores desistiu. Ainda há um desequilíbrio no preço das GPUs, NVIDIA e AMD estão detonando o povo early adopter. Uma RTX 4090 sai por mais de US$ 2 mil se você escolher marcas mais famosas.

Já no segmento intermediário, os preços estão bem mais razoáveis, sendo controlados pela grande quantidade de placas usadas que chegaram ao mercado, mas você tem que procurar bem. Mesmo placas como minha jurássica 1050 Ti variam de R$ 900 a R$ 1.500.

Status Quo

Trabalhar com Inteligência Artificial demanda muita capacidade da GPU, mesmo no ambiente doméstico, mas o povo do Open Source tem otimizado as ferramentas de uma forma incrível, e mesmo modelos parrudos como o Stable Diffusion XL rodam mesmo na GeForce 1050 Ti, com apenas 4 GB de VRAM, usando o otimizadíssimo Fooocus.

Quem tem paciência, e só quer gerar imagens, está bem-servido com uma GPU com 8 GB de VRAM, mesmo das antigas.

NOTA: A quantidade de memória e a capacidade da GPU NÃO AFETAM a qualidade da imagem gerada. Apenas o tempo de gerar a imagem será mais longo. As operações matemáticas são as mesmas, independente da GPU.

Mais um teste do Stable Diffusion XL

A coisa complica quando você quer fazer animações, criar imagens com maior resolução, fazer upscaling de imagens existentes, treinar LORAs e Textual Inversions, ou usar LLMs e sintetizadores de voz.

Aí VRAM é rei, e a Nvidia é a Rainha Louca, limitando VRAM em suas GPUs gamers para não esvaziar o muito lucrativo mercado das GPUs profissionais.

A discussão então se focou em achar a melhor relação custo/benefício para quem não tem uma fortuna para dar numa 4090, qual o melhor compromisso entre desempenho, flexibilidade e preço. O consenso, algo muito raro de se conseguir na Internet, foi que a GeForce 3060 com 12GB de VRAM era a resposta mais adequada.

Habemus GeForce RTX 3060/12 GB

Antes de comprar a placa, fiz uma pesquisa detalhada, e descobri que minha fonte de 450W não era adequada. O recomendado pela Nvidia para a 3060 é uma fonte de pelo menos 600 W. Optei por uma Red Dragon, e está funcionando direitinho, com a vantagem de ser full modular e isso ajuda a deixar o gabinete mais espaçoso, com melhor fluxo de ar.

Feito isso, fui no bom e velho BoaDica, site que agrega todas as lojas e quiosques de informática do InfoCentro, aqui no Rio, e pesquisei pela GeForce RTX 3060/12 GB.

Imagem criada usando Stable Diffusion XL

ALERTA:

A Nvidia, em sua infinita sabedoria, resolveu os problemas de falta de memória que atormentavam muitos usuários, alterando seus drivers para fazer swap em RAM, o que torna a execução de aplicações como o Stable Diffusion DEZ VEZES mais lenta.

Para evitar isso, reinstale o driver da NVIDIA para qualquer versão 531.xx ou inferior.

Comparação inicial: 1050ti vs 3060

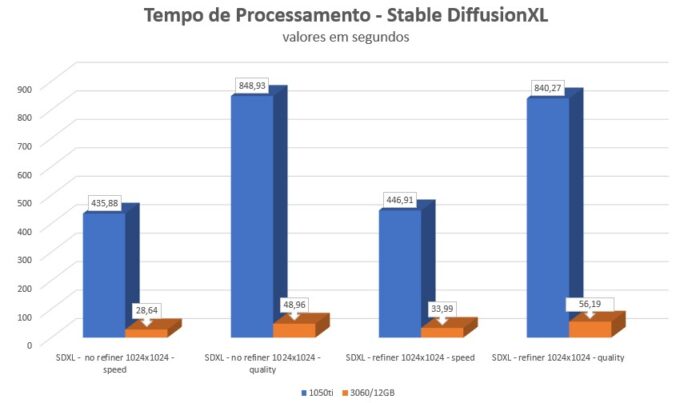

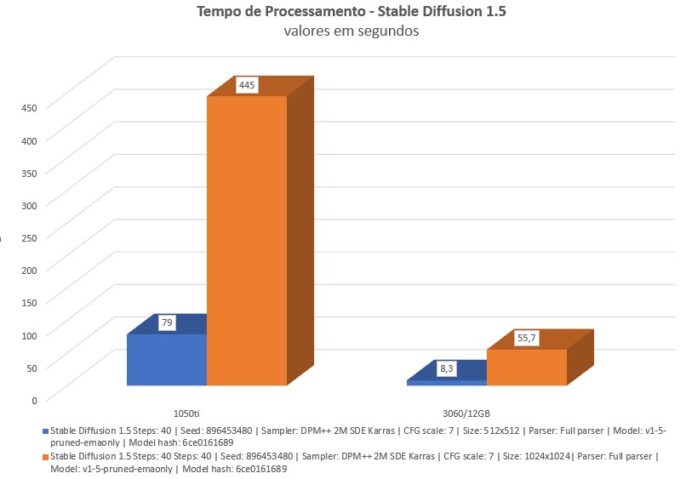

OK, admito, eu estava resignado com a 1050ti criando uma imagem 512x512 em 79 segundos, mas não estava preparado para ver a mesma imagem sendo criada em 28 segundos. É um massacre do nível Tucão Versus Galactus.

Esses números são no Stable Diffusion XL, que gera resultados excelentes, mas é bem mais parrudo, os modelos costumam ter 6 GB de tamanho, então nem são carregados inteiros na 1050 Ti.

Usando Fooocus, identifiquei uma variação de velocidade na 3060 que dependendo do cenário, a deixava entre 13 e 17 vezes mais rápida. É o que os gringos chamam de Game Changer.

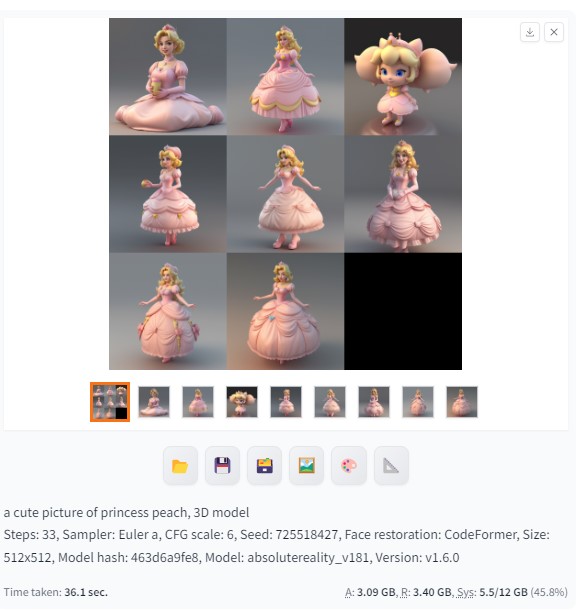

Um dos segredos da geração de imagens via IA, é que você não gera UMA imagem, você gera um caminhão delas, escolhe as melhores, e as refina, usando IA ou o bom e velho Photoshop.

Com o Stable Diffusion XL isso era inviável, imagine levar 14 minutos para cada imagem. Agora com 28 segundos, mal dá tempo de comandar a geração e buscar um café.

Stable Diffusion 1.5

Sim, eu sei, existe o Stable Diffusion 2.0 mas a primeira regra do clube do Stable Diffusion é que não falamos do 2.0.

O 1.5 ainda é a versão mais versátil, com acesso a todos os recursos de LORAs, Checkpoints, ControlNets e etc, e no caso a geração de uma imagem no tamanho-padrão de 512 x 512 cai de 79 segundos para 8,3 segundos, mas essa nem é a principal vantagem.

Há dois ganhos aqui: A 3060/12 GB permite que eu gere imagens mais rápido, mas não se esqueça, estamos no paraíso do paralelismo. O Stable Diffusion aproveita todos os 3584 núcleos CUDA da 3060, e gera OITO imagens simultâneas em 36.1 segundos, o que dá 4.5 segundos por imagem.

O segundo ganho é que com 12 GB de VRAM, é possível usar vários recursos encadeados, como LORAs, para modificar as imagens, AnimateDIFF para, bem, criar animações, DEFORUM para otimizar essas animações, ControlNET para especificar a pose dos personagens, tudo ao mesmo tempo.

Exemplo de imagem crada usando ControlNet

E outros recursos de IA, a 3060 é boa?

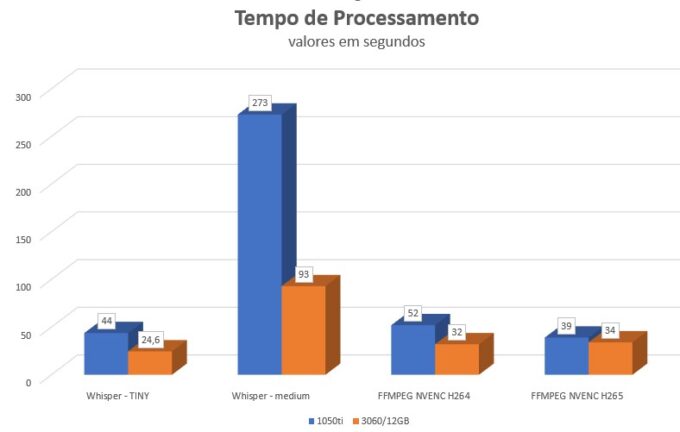

Excelente pergunta, Pequeno Gafanhoto. Sim, eu testei a 3060 com o Whisper, aquela aplicação de IA usada para transcrever e traduzir áudio. A principal vantagem é que a 3060 aguenta carregar os modelos maiores e mais complexos, e mesmo com o modelo médio do Whisper, ela transcreveu áudio três vezes mais rápido que a 1050 Ti.

Os 12 GB também permitem que ela rode aplicações como o Bark, para geração de narrações em texto e clonagem de vozes, ou LLMs que funcionam mais ou menos como o ChatGPT, só que rodando localmente.

Ferramentas de restauração de imagens também se beneficiam com o excesso de memória.

Uma das aplicações que o povo está usando direto é o SadTalker, usada para fazer vídeos de “talking heads”, que estão invadindo o TikTok e rendendo uma boa grana. Com a 3060 é trivial produzir esses vídeos.

E Games, a 3060 entrega?

Ah sim, não dá pra reclamar. Ela tem ray tracing, 12 GB de VRAM, DLSS e todas as buzzwords que o povo gamer gosta. Eu consegui 180 fps no Battlefield 4, e mais de 90fps no Battlefront 2, detalhe que meu monitor é 2560 x 1080, ultrawide. Equivale a quase dois monitores Full HD.

É uma placa que vai funcionar para games por vários anos, que é o que espero de uma boa GPU.

Conclusão

A GeForce RTX 3060 é uma placa que hoje a Nvidia não lançaria, ela apresenta um custo/benefício excelente para quem quer estudar Machine Learning, Inteligência Artificial, LLMs, Stable Diffusion, mas sem quebrar o banco, ou roubar um, a única forma de comprar uma 4090 no Brasil.

Estrategicamente faz mais sentido para a Nvidia empurrar o consumidor para placas mas caras.

Seu grande diferencial são os 12G B de VRAM, então desde já repito: Não, a 3060 Ti não é uma opção, apesar de ser mais rápida. Com apenas 8 GB, ela vai limitar bastante a complexidade do que você pode fazer com ela.

Vantagens:

- 12 GB de VRAM;

- Tamanho pequeno, não precisa de gabinete grande;

- Baixo consumo, trabalhando apenas no desktop, usa 25 W;

- Suporte a Tensor Cores, RayTracing, DLSS e outros recursos modernos.

Desvantagens:

- O preço, entre R$ 1.700 e R$ 2.000, ainda é puxado;

- Exige uma fonte de pelo menos 600 W, quando em uso pesado o consumo passa de 160 W;

- Só tem uma saída HDMI, as outras três são Displayport.

Recursos Adicionais:

- Automatic1111 – WebGui mais versátil para usar o Stable Diffusion 1.5;

- AnimateDiff – extensão de animação para o Automatic1111;

- Fooocus – WebGui para Stable Diffusion XL – simples e fácil de instalar;

- ComfyUI – a mais poderosa interface para o Stable Diffusion, mas danada de complexa;

- BoaDica - site de busca de preços e produtos para lojas físicas no Rio de Janeiro;

- Bark - Aplicação de IA para geração de fala.