GPU Wars, Episódio 1: “ATi e a Irmandade do fotograma bidimensional”

Retrospectiva sobre o ramo dos processadores gráficos, cujo período analisado vai de 1987 a 1995, ao abranger desde as GPUs “burras” 2D até a aceleração de ‘rudimentares’ gráficos tridimensionais via hardware: o personagem principal escolhido foi a ATi, cuja trajetória vai de encontro com a então estreante nVidia.

Emanuel Laguna 14 anos atrás

Há aproximadamente 23 anos, em julho de 1987, uma pequena companhia canadense de hardware, a ATi, lançava a primeira linha de placas de vídeo no varejo, com sua própria marca, após 2 anos desenvolvendo chips de exibição de vídeo para grandes montadores de PCs à época, como IBM e Commodore, sob o regime OEM.

Era a linha Wonder, em versões EGA e VGA, esta lançada pouco menos de um ano depois, com preços na faixa dos 400 dólares.

Logotipo da ATi no século XX.

Essas duas placas ISA (8 bits) tinham, respectivamente, 256 KiB e 1 MiB de memória DRAM (cuja interface também era 8 bits).

O detalhe interessante da versão EGA era oferecer uma resolução proprietária de 800x600 / 4 bits, além da padrão 640x350 / 6 bits. A versão VGA, de 1988, além de substituir o conector DE-9 pelo homônimo azul de 15 pinos que sobrevive até hoje, também teve um modelo mais barato, com 512 KiB de memória ‘burra’ de vídeo.

Sim, até o final dos anos oitenta, as primeiras placas de vídeo eram consideradas “dispositivos burros”, pois o rudimentar chip gráfico apenas recebia a imagem gerada pela CPU, ao atualizar a imagem armazenada na memória de vídeo (framebuffer) com relação à imagem visualizada propriamente dita.

A situação começou a ficar mais ‘inteligente’ quando a ATi lançou no mercado, em 1991, o Mach 8, um modesto processador gráfico cujas funções e API eram plenamente compatíveis com a IBM 8514, uma plataforma de placas de vídeo que suportava aceleração, via hardware, de algumas funções fixas na renderização e manipulação de gráficos bidimensionais no DOS.

No processador gráfico lançado no ano seguinte, o Mach 32, a ATi adicionou aceleração via hardware às GUIs 2D com precisão de até 32 bits (a 24 bits de côres), ao suportar basicamente a API gráfica padrão do DOS e, de forma limitada, o VESA VBE.

Assim como o Mach 8, o Mach 32 também equipava as placas de vídeo “clones” do IBM 8514, sob as marcas Graphics Wonder e Graphics Ultra.

A diferença entre ele e o Mach 8, além do pioneiro suporte ao slot PCI, era que o Mach 32 possuía o núcleo VGA integrado num mesmo chip, que nem os concorrentes do varejo à época, como o Cirrus Logic CL-GD5422, o S3 928 e o Trident TVGA 9000, além de interface 64 bits com a memória (máximo de 2 MiB), esta do tipo VRAM.

O Brasil tornou-se tetracampeão no mesmo ano (olá, 1994!) em que a empresa aparece no mercado com as placas de vídeo Graphics 3D Xpression, equipadas com o Mach 64.

A GPU Mach 64 oferecia precisão 2D de 64 bits (a 24 bits de côres) e até 8 MiB de memória EDO a também 64 bits, mas não somente isto: jogos como Alone in the Dark e Doom eram beneficiados com uma mínima aceleração de gráficos tridimensionais, aspecto pioneiro no concorrente da Matrox, a GPU das Impression Plus, mas que a S3 Vision968 e a Trident TGUI 9440, por exemplo, não tinham.

Uma versão melhorada do Mach 64, a GT, foi posta no mercado em 1995 e equipava as placas de vídeo Rage 3D.

O Mach 64 GT dava suporte à aceleração via hardware do codec MPEG-1, além de ser compatível com uma certa API gráfica proprietária da titia Microsoft, o Direct3D, presente no DirectX 2.0a e implementada no recém lançado Windows 95 OSR2.

O processador gráfico em si era bem simplório, comparado com o que temos hoje: o Mach 64 GT andava a 40 MHz e era composto por uma única unidade lógica e aritmética (ALU) pouco programável, que iniciava o único pixel pipeline da pipeline gráfica toda, aqui constituída por apenas uma simplória unidade texturizadora (TMU) e uma rudimentar unidade rasterizadora (ROP). Para manter o preço competitivo, a placa Rage 3D tinha apenas 2 MiB de memória EDO a 40 MHz, com interface 32 bits.

"Tio Laguna, e quem competia diretamente contra a Rage 3D?"

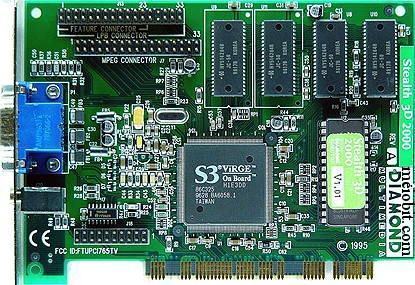

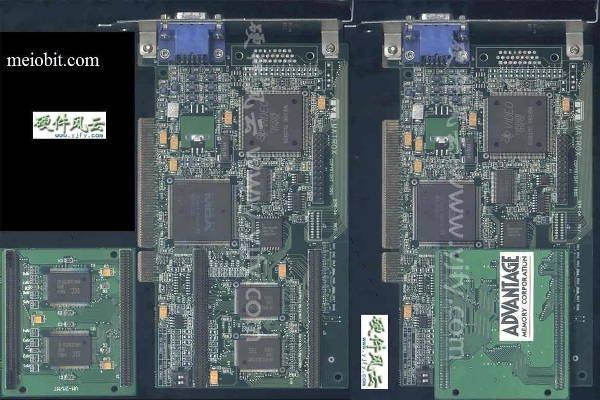

Bom, da S3 tinhamos a GPU ViRGE, sucessora das Trio e Vision. Este processador gráfico equipava as Stealth 3D, uma série de placas de vídeo fabricadas pela Diamond.

Essa GPU ViRGE, lançada em 1995, tinha basicamente a mesma configuração do Mach 64 GT (inclusive também compatível com o Direct3D), com 1 ALU + 1 TMU + 1 ROP (aqui na ViRGE todos esses componentes do chip gráfico correm a 66 MHz) e sua respectiva placa de vídeo (Diamond Stealth 3D 2000) tinha 4 MiB de DRAM-66 MHz com interface 64 bits.

Outro concorrente bem interessante de 1995 era a Matrox Storm R2 2064W, que equipava as profissionais placas de vídeo Millennium.

Para obtermos os simplórios gráficos tridimensionais dos jogos da época, as placas de vídeo Millennium deveriam funcionar em conjunto com alguma placa Impression, cuja GPU MGA Atlas/Athena R1 apenas acelerava gráficos bidimensionais de funções fixas em CAD.

Além da compatibilidade com o Direct3D, as Millennium mantinham a sólida compatibilidade das Impression com a primeira versão da API OpenGL. Em termos de especificações técnicas, a única diferença entre a placa Millennium e a placa Stealth 3D era a freqüência de operação da GPU e da memória, ambas a 50 MHz.

Isso, fora o facto de o Matrox Storm R2 2064W ser um processador gráfico de uso exclusivo em renderização de imagens 3D, ao necessitar de outra placa para a aceleração de gráficos bidimensionais. Inclusive tal configuração permitia o uso de dois monitores (um em cada placa de vídeo), embora a imagem gerada fosse basicamente a mesma em ambas as saídas VGA.

Além dos concorrentes já citados, a ATi completaria 10 anos de existência presenteada com um pioneiro lançamento daquela outra empresa, que seria sua atual arqui-rival no ramo dos processadores gráficos:

Em setembro de 1995, a Diamond aparece com uma nova linha de placas de vídeo, a Edge 3D. Adivinhem de quem era o processador gráfico que equipava tais placas de vídeo?

Ela mesma, a nVidia. O processador gráfico NV1 era fabricado pela SGS-Thomson Microelectronics sob o nome STG-2000. As placas de vídeo (ainda estamos nos slots PCI, gente) equipadas com o NV1 tinham uma característica peculiar: eram basicamente um (provavelmente bem caro) sistema completo de entretenimento multimídia.

Pelo menos era o que dava a entender tantas outras funções e seus respectivos conectores: além da óbvia saída VGA azulzinha, tinhamos conexão ethernet (10 Mbps), processador de áudio (apenas reprodução) integrado de 32 canais (seis saídas por três conectores TRS aka P2) e duas entradas para joypads do SEGA Saturn, um console da quinta geração, famoso pela complexa arquitetura.

Mas o relacionamento entre a nVidia e a SEGA não se limitava ao suporte, no PC, dos gamepads do complexo console de 32 bits: assim como o Saturn, os 200 mil transístores do NV1 renderizavam gráficos tridimensionais baseados em quadriláteros (QTM), na API proprietária e exclusiva do NV1, incompatível com o Direct3D.

O porém era que, naquela época (e mesmo hoje!), a quase totalidade das APIs gráficas mexiam com gráficos tridimensionais cujas primitivas geométricas eram triângulos. Aliás, os únicos jogos em 3D compatíveis com a placa de vídeo Diamond Edge 3D eram alguns portados “diretamente” do Sega Saturn para o PC.

Bom, ao menos o processador gráfico NV1 era compatível com a API gráfica padrão do DOS, embora o desempenho não fosse espetacular nos jogos 2D suportados por tal API gráfica: provavelmente a taxa de fotogramas por segundo deveria ser bem menor que as soluções em processamento gráfico high-end da época, algumas inclusive citadas no presente artigo.

O tio Laguna deseja que os leitores do Meio Bit, inclusive o próprio, tenham aproveitado bastante toda a presente retrospectiva sobre a era bidimensional dos processadores gráficos e sua gradual evolução, até as primeiras GPUs com aceleração de ‘rudimentares’ gráficos 3D via hardware, em tempo quase real.

Fica a pergunta: será que algum de vocês já testou alguma dessas lendárias placas recentemente?

[ATUALIZAÇÃO 1]

Como o presente texto aborda de 1987 a 1995, talvez a maioria de vocês não tenha tido acesso à tais processadores gráficos. Talvez, no segundo episódio da saga GPU Wars, a memória dos caros leitores do Meio Bit, sobre os anos 1996 e 1997, esteja ainda mais afiada. Assim, espero.