Teremos Robôs assassinos com ChatGPT?

A novidade agora é que querem integrar IA com robôs, efetivamente dando cérebro a nossos futuros mestres mecânicos, mas a realidade é que isso não é possível com a tecnologia atual, entenda

Carlos Cardoso 29/02/2024 às 17:32

Robôs são naturalmente associados à Inteligência Artificial, mais do que merecem. Hoje em dia nossos robôs são pouco mais que marionetes glorificadas, mesmo o poderoso Atlas da Boston Dynamics, mas há quem queira mudar isso.

- GPT-3 - Entrevistamos o fantasma na máquina

- Pesquisadores puxam tomada de IA que aprendeu a escrever bem demais

Crédito: Stable Diffusion

A Figure AI anunciou uma captação de US$675 milhões, de nomes como Microsoft e Jeff Bezos, com objetivo de investir em pesquisas para criar modelos de IA utilizáveis em robôs.

De um certo modo, faz sentido. Uma das maiores dificuldades dos robôs atuais é entender o mundo à sua volta, um robô não sabe a diferença entre uma pessoa e uma cadeira, para ele são só obstáculos.

Um robô não entende comandos genéricos como “pegue aquele ovo ali”, se ele não tiver sido programado para reconhecer um ovo. A IA dos robôs nunca foi generalista, por mais que tenham vendido a idéia, como a tal Sofia, que era apenas um truque de salão. Hoje qualquer um tem algo muito mais sofisticado rodando via navegador.

Os LLMs evoluíram muito rapidamente, sendo capazes de conversar naturalmente, fazer piadas e até entender duplo-sentido e sarcasmo, algo além das capacidades da maioria dos NPCs. Assim, naturalmente, o caminho lógico é enfiar um LLM em um robô, e presto! Habemus C3P0, Demerzel, Caprica 6 ou o Exterminador do Futuro.

Só que não.

Os Large Language Models são excelentes para compreender textos, idéias, conceitos, mas eles não são realmente inteligentes, por mais que engenheiros piroga das idéias do Google digam que sim.

Seu cérebro está sempre em atividade, mesmo enquanto você assiste Big Brother. Você está processando informação internamente, memórias estão sendo fixadas e descartadas, inputs de mais de 10 sentidos estão sendo continuamente processados. Fora toda a parte de manutenção do corpo e do metabolismo.

Um LLM quando não está em uso, é uma matriz multidimensional estática de dados.

Brevíssima Explicação sobre LLMs

Uma IA como o ChatGPT, Gemini ou Copilot é essencialmente um imenso amontoado de estatísticas e probabilidades, construído analisando terabytes de textos. Essa rede neural é treinada para identificar padrões e probabilidades entre tokens

Você não* (Crédito: South Park Studios)

(* EU SEI)

No caso, um token pode ser uma palavra, uma frase, ou até parte de uma palavra. Digamos que você está começando uma história, e a escreverá o resto. Você digita “Era”. A IA começa a pesquisar estatisticamente quais palavras estão mais associadas com “Era”.

Pode ser por exemplo:

“Era do”

“Era tarde”

“Era cedo”

Mas estatisticamente, em termos de história, a palavra mais comum associada é “uma”. Agora a IA tem dois tokens, e busca mais associações. O mais comum associado com “era uma” é “vez”. E daí segue, mas com variações aleatórias e criatividade variada.

Óbvio que com três palavras não se vai muito longe, mas estamos falando de LLMs com bilhões de parâmetros, são em alguns casos dezenas de bilhões de neurônios influenciando uns aos outros, e dessa complexidade que nasce a linguagem natural que tanto nos surpreende.

A criação dessa matriz demanda muito processamento, custa uma fortuna e pode levar vários meses, mas depois de treinado, o modelo roda em condições relativamente modestas, mas há um porém: É um modelo estático. Alguns usam a analogia de uma foto do cérebro, mas é pior que isso.

Redes neurais, segundo uma rede neural (Crédito: Stable Diffusion)

Uma IA tipo LLM tem um único input, um prompt que essencialmente é texto, mas pode ser vídeo, áudio, etc. Ele não recebe dados de outras fontes, não é influenciado pela hora do dia, temperatura, se precisa ir ao banheiro. Ele irá processar o prompt, cuspir o resultado e voltar a hibernar.

O próximo prompt será respondido da mesma forma, e a menos que haja algum esforço externo por parte dos desenvolvedores, ele não será afetado pelos prompts anteriores. Um LLM não tem memória, não aprende com experiências antigas. Ele é uma ferramenta stateless como dizíamos antigamente.

“Ah Cardoso, mas o ChatGPT tem histórico, ele lembra das conversas”

Sim, todo LLM tem um buffer de tokens, o ChatGPT 3.5, por exemplo, limita os inputs a 4096 tokens. Internamente ele usa um limite maior, para introduzir no prompt informações dos chats anteriores, criando uma espécie de memória de curto prazo.

Um robô usando um LLM como cérebro seria péssimo, em algumas horas ele esqueceria o começo da missão, e ficaria mais perdido que robô cego em tiroteio.

“Então LLMs são inúteis para robôs?”

Negativo, LONGE disso. Recentemente a Klarna, empresa especializada em callcentres de suporte técnico, divulgou que usando IA eles fizeram o trabalho de 700 funcionários, respondendo 2/3 das chamadas mensais recebidas pela empresa. Detalhe, com 25% a menos de taxa de retorno. Ou seja: Os clientes tiveram seus problemas resolvidos.

Sejamos realistas, por mais que tenham que seguir script, callcentre de nível 1 é um horror, eu faço tudo pra não ter que ligar. Uma vez tive que perder a paciência com uma atendente da TELEMAR. “Filha, olha só. Eu NÃO VOU resetar o modem. Que parte de ‘um caminhão sem freio desceu a ladeira e arrancou todos os cabos da rua’ você não entendeu?”

Um ChatBot usando um LLM pode ser facilmente configurado para buscar dados em tempo real, e tem uma capacidade muito superior a um atendente, para correlacionar esses dados com o problema do usuário. Não é difícil imaginar em pouquíssimo tempo algo como a Roberta, a recepcionista-robô do Quarteto Fantástico.

Robôs de combate com IA baseada em LLMs aparecerão nos próximos anos, isso é uma certeza, imagine um Spot, da Boston Dynamics, mas capaz de observar um combate, identificar inimigos e alertar os soldados, ou verificar que um grupo está ficando sem munição, e sozinho ir buscar mais cartuchos.

A capacidade de reconhecimento de imagem dos LLMs é excelente, associe isso a um robô e temos sentinelas / unidades de reconhecimento melhores que qualquer humano.

Isso tudo, com a tecnologia que temos hoje. A Ciência está tão rápida que já emparelhou com a ficção. Em 2008 todo mundo ficou maravilhado com esta cena no Homem de Ferro:

Pura ficção científica, isso nunca vai existir! (Crédito: Marvel Studios/Disney)

Terroristas capturam reféns durante o ataque de Tony Stark a uma base dos Dez Anéis. Usando a tecnologia da armadura, os civis são identificados e mini-mísseis atingem somente os terroristas. Na época teve crítico da Veja dizendo que esse era o sonho molhado dos militares americanos, uma arma que só matasse inimigos, sem atingir civis inocentes. O curioso é que ele falou isso em tom de crítica.

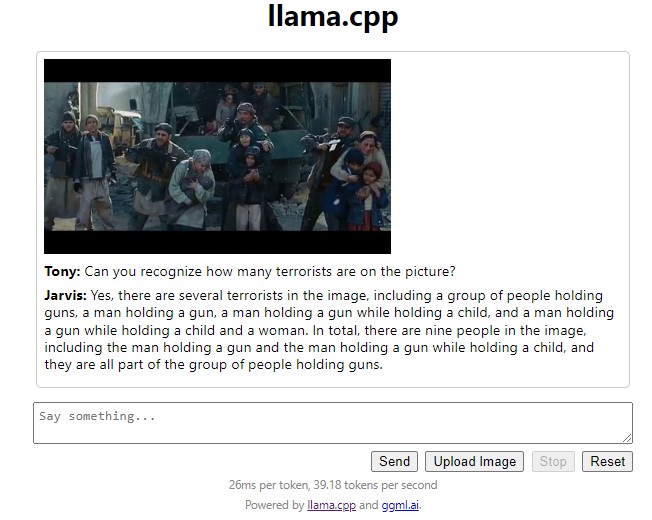

Pois bem, em 2024 eu peguei o Llava, um modelo de meros 7 bilhões de parâmetros, usei um único frame da cena, e mandei ele identificar se havia algum terrorista.

Nada mau para quem não tem o Jarvis em casa (Crédito: Meio Bit)

O diabo não só identificou terroristas como descreveu a maioria, com os reféns de cada um. Ele errou o total de pessoas na imagem, o que é compreensível. É um modelo ultrapassado, quantizado para ocupar menos memória, perdendo precisão no processo, mesmo assim esse resultado, que foi o PRIMEIRO que obtive, é impressionante.

Extrapole isso para modelos de alto desempenho rodando em supercomputadores, conectados por links encriptados, e você pode ter um enxame de robôs altamente inteligentes.

O povo entusiasmado com a AGI, sigla em inglês para Inteligência Artificial Generalizada, está fingindo que não entende a dificuldade envolvida. É ruim para o ego de quem exerce atividade criativa, mas está demonstrado que não é preciso real inteligência para escrever textos ou criar ilustrações. Um robô não precisa pensar para criar um relatório, escrever a sinopse de um filme ou atirar na sua fuça mesmo você achando que estava camuflado.

Se serve de consolo, o robô não fará isso por odiar você, não é o prenúncio da Skynet, ele estará obedecendo ordens simples, não haverá nenhum cérebro funcionando o tempo todo, filosofando sobre sua condição e a Existência.

Combate não é lugar para ficar devaneando, um robô controlado por um LLM, com missão específica é muito melhor do que um robô senciente, com noção da própria existência, que ele eventualmente tentará proteger. Nas palavras do filósofo Maverick:”

“Confie nos seus instintos! Não pense, apenas faça. Você pensa lá em cima, você está morto.”

Claro, em um mundo ideal poderíamos extrapolar robôs com LLMs em tudo. Imagine uma mina terrestre com capacidade de diferenciar entre soldados amigos, inimigos e crianças. Isso seria-nah, caro demais. Isso não vão implementar.