IA: "veneno" em imagens pode destruir modelos generativos

Nightshade é um algoritmo que injeta "veneno" em imagens usadas para treinar modelos de IA generativa, que quebram de forma irreversível

Ronaldo Gogoni 20 semanas atrás

Enquanto muita gente anda maravilhada com os benefícios da IA generativa, desde que ChatGPT, Stable Diffusion, DALL-E e outros entraram em evidência em 2022, outros estão fulos da vida com os métodos usados para o treinamento dos algoritmos, que usaram quantidades pantagruélicas de textos, imagens, artes, vídeos e conteúdos diversos, muitos protegidos por direitos autorais, e claro, sem pagar um tostão sequer aos detentores dos copyrights.

- IA: Estados Unidos ensaia processo de regulação

- IA: identificar conteúdo é mais difícil do que se pensava

Pesquisadores dizem que o Nightshade, quando presente em imagens suficientes, pode quebrar modelos de IA de forma irreversível (Crédito: qimono/Pixabay)

De lá para cá, pipocam processos de gente grande, como George R.R. Martin e John Grisham contra a OpenAI, ou do vencedor do Pulitzer Michael Chabon contra o Meta, no que ChatGPT e Llama, entre outros, podem emular seus estilos literários e de muitos outros autores.

Há também ações conjuntas, movidas por indivíduos contra companhias como Stability AI, Midjourney, e DeviantArt, por estas usarem artes de seus usuários para treinar seus próprios modelos, com ou sem consentimento prévio; o Google também é alvo de uma ação semelhante, bem como a OpenAI, de novo.

Os processos não se atêm à emulação de estilos artísticos ou literários, porque o look and feel de uma obra não é passível de patentes ou copyrights, como bem definido no caso da Apple contra a Microsoft e a HP. O rolo, que envolveu até a Xerox, foi baseado na acusação de que ambas empresas copiaram a interface gráfica do Alto; a maçã tentou estabelecer direitos sobre a GUI do Apple Lisa, que Bill Gates teria copiado com o Windows. No fim, não deu em nada.

A Lei de IA da União Europeia, prevista para entrar em vigor entre 2025 e 2026 (isso porque os legisladores ainda não chegaram a um consenso), lida com a cópia de conteúdos protegidos, obrigando empresas responsáveis pelos modelos generativos a revelarem, sem exceções, todas as fontes usadas nos treinamentos de suas IAs, intencionalmente para viabilizar processos contra OpenAI e cia. pelas partes afetadas, sejam companhias, estúdios, autores ou artistas, grandes ou pequenos.

Nem todo mundo dispõe de verba para pagar por advogados e longos processos, especialmente artistas freelancers, que também tiveram suas obras coletadas e usadas para treinar IAs das mais diversas. Sites como o Have I Been Trained inclusive são capazes de fazer pesquisas extensas, identificando modelos usados que pertencem a autores, desenhistas, fotógrafos e até cosplayers, no que todos tiveram seus conteúdos coletados e usados, sem que fossem consultados, muito menos remunerados.

Foi pensando nessa turma que pesquisadores da Universidade de Chicago desenvolveram um método de ataque a modelos de IA generativos para a criação de imagens, como Stable Diffusion e outros, chamado Nightshade. O nome não vem do acaso, é a versão em inglês da nomenclatura popular da Atropa belladona, conhecida no Brasil como beladona, uma das plantas mais tóxicas do planeta, no que a ingestão de uma única folha é o suficiente para matar um adulto.

O Dr. Ben Y. Zhao, professor do departamento de Ciências da Computação da Universidade de Chicago, e líder do estudo (cuidado, PDF), é um ferrenho crítico das práticas de coleta indiscriminada de conteúdos alheios pelas companhias de IA para treinar seus modelos. Seu time desenvolveu o Nightshade como um método para "envenenar" algoritmos, quando estes entram em contato com imagens manipuladas previamente.

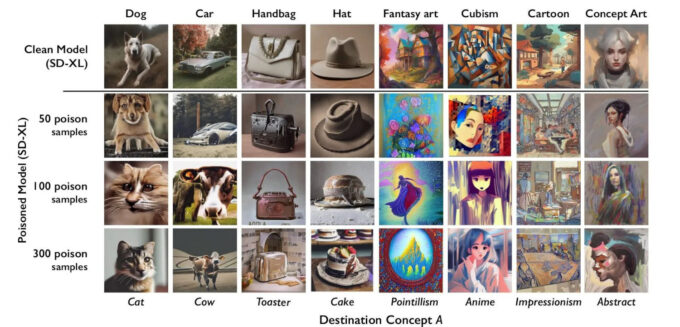

Exemplos de como o "envenenamento" por Nightshade afeta modelos generativos; com o tempo, eles passam a entender uma solicitação como algo completamente não relacionado, e não tem volta (Crédito: Reprodução/University of Chicago)

Nightshade quebra modelos de IA

Funciona assim: o Nightshade altera os dados de uma imagem, manipulando seus pixels de forma imperceptível a olho nú, mas o suficiente para bagunçar com os parâmetros dos modelos que a usarem como base de treinamento. Basicamente, estas imagens estão corrompidas e não podem ser devidamente identificadas manualmente, mas uma vez que elas entram no banco de dados, os dados manipulados são contabilizados.

Uma vez que a quantidade de imagens "envenenadas" se acumula no banco, o modelo generativo começa a alucinar, o que é intensificado quanto mais fotos ou artes que incluam o Nightshade ele use, e ao chegar nesse estágio, a IA desaprende os modelos e parâmetros anteriormente estabelecidos.

No estudo, uma contaminação com 50 imagens manipuladas pelo Nightshade já são suficientes para fazer com o que o Stable Diffusion XL tenha dificuldades em interpretar uma solicitação do usuário, e as imagens resultantes são distorcidas. Com 300 imagens, ele passa a confundir completamente os pedidos, criando gatos ao invés de cachorros, bolos no lugar de chapéus, e artes no estilo anime ao invés do cubismo, entre outros casos.

A beleza do Nightshade, do ponto de vista de Zhao, reside no fato que o envenenamento de um modelo generativo é irreversível; uma vez contaminado, ele se torna inútil. Como se não bastasse, os algoritmos são (por enquanto) incapazes de identificar previamente se uma foto ou arte foi manipulada, e teoricamente também não é fácil de ser detectada por métodos automáticos (Photoshop, etc.), pois a manipulação dos pixels é feita de modo a parecer natural.

De certa forma, só quem sabe o que está procurando, e como procurar, será capaz de identificar, entre duas versões de uma mesma imagem, qual não foi alterada e qual contém uma dose letal de Nightshade. O artigo descreve, com uma quantidade razoável de detalhes (ele está em fase de preview, pré-revisão por pares), como o "veneno" digital atinge ambos objetivos.

Claro, ferramentas como o Nightshade, ou outras criadas para imunizar imagens, não farão grande diferença para modelos já estabelecidos e devidamente treinados, como o SDXL e o recente DALL-3, mas poderão se tornar fontes de dores de cabeça para futuras implementações, caso tais algoritmos sejam distribuídos (se gratuitamente ou vendidos, veremos) entre os detentores dos direitos dos conteúdos usados para treinar IAs sem permissão.

De qualquer forma, este é mais um capítulo do agora estabelecido jogo de gato e rato, entre as companhias de IA que querem coletar tudo da internet para treinar seus modelos sem pagar, e os criadores de conteúdo que não ganham nada com isso.

Referências bibliográficas

SHAN, S., DING, W., PASSANANTI, J. et al. Prompt-Specific Poisoning Attacks on Text-to-Image Generative Models. arXiv (Cornell University), 19 páginas, 20 de outubro de 2023. Disponível aqui.

Fonte: MIT Technology Review