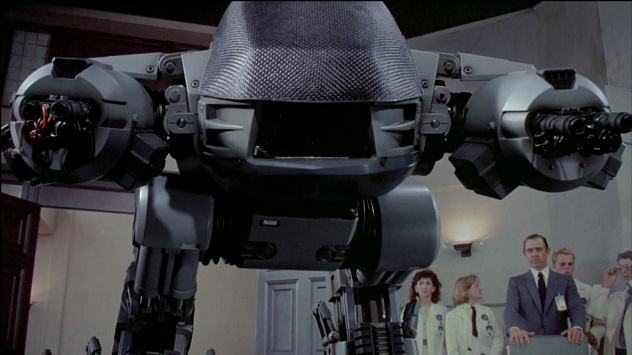

Em breve: drones com poder de decisão para atacar, o que poderia dar errado?

Algumas ideias parecem retiradas diretamente de algum plano de Pink e Cérebro, com o agravante que na prática seriam um desastre, ao invés de engraçadas. Essa é uma delas.

j. noronha 10 anos e meio atrás

Algumas ideias parecem retiradas diretamente de algum plano de Pink e Cérebro, com o agravante que na prática seriam um desastre, ao invés de engraçadas. Essa é uma delas.

Cientistas, engenheiros e legisladores estão trabalhando para encontrar maneiras mais inteligentes de utilizar drones militares, os famosos veículos não-tripulados da destruição (literalmente, nesse caso).

A bola da vez é dotá-los da capacidade de decidir quando e onde efetuar um ataque mortal, sem interferência humana em qualquer fase do processo.

O objetivo seria reduzir os danos a civis em um ataque, desde que você ache que "reduzir danos" é algo aceitável quando você mora em uma área com um grande alvo pintado em cima. Eu já preferiria algo como "dano zero", mas né?

Segundo o professor Samuel Liles, da Universidade de Purdue:

Um drone com um sistema sofisticado o suficiente pode ser menos emotivo, mais seletivo e capaz de desenvolver um ataque com menos danos. Um drone letal autônomo pode mirar melhor e escolher alvos melhor...

Só faltou a parte do "por que esses olhos tão grandes?".

Agora, para o choque de realidade

Enquanto o professor Liles sonha com sistemas lindos e maravilhosos que funcionam como uma máquina bem lubrificada, a realidade passa bem longe disso.

Ano passado, por exemplo, um engenheiro ouvido pelo comitê de segurança nacional dos Estados Unidos afirmou que com equipamento barato e fácil de encontrar é possível hackear um drone e sequestrá-lo para uso próprio. Algo como arremessar um bumerangue e recebê-lo de volta na cabeça.

A notícia não é nem novidade, em 2009 milícias bancadas pelo Irã usaram software que é facilmente encontrado em literalmente qualquer lugar para interceptar o feed de vídeo de drones sobrevoando o país. O custo desse software? Astronômicos 26 dólares. Detalhe: ele foi utilizado sem qualquer modificação do código-fonte original.

Se isso já não fosse motivo suficiente para preocupação, em 2011 um vírus infectou alguns sistemas de controle de drones em uma base aérea de Nevada (EUA).

O grande problema é que, independentemente da segurança do sistema, um drone não é capaz de diferenciar um talibã de uma aluna do jardim da infância, como afirma a muito mais sensata professora Heather Roff, da Universidade de Denver.

"A ideia de que podemos resolver uma crise com uma arma robótica é ingênua e perigosa", afirma Roff.

Agora é esperar, porque as más ideias geralmente vão em frente, principalmente quando nossos amigos do norte estão envolvidos.

Fonte: National Journal