Relatórios falsos criados por IAs são capazes de enganar especialistas

Estudo usou IAs para criar relatórios médicos sobre COVID-19 e de cibersegurança, que profissionais não conseguiram identificar como falsos

Ronaldo Gogoni 3 anos atrás

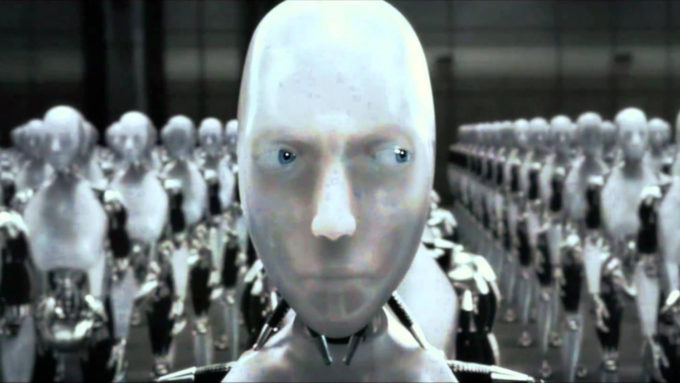

IAs e sistemas especialistas podem ser ferramentas muito úteis quando bem utilizadas, mas por outro lado, são capazes de realizar estragos sem precedentes quando dedicadas a atividades ilícitas. Softwares geradores de texto, como o GPT-3 da OpenAi, vêm causando dores de cabeça desde sua criação, pois humanos são humanos.

- Lei da UE para regular IAs e reconhecimento facial possui falhas

- Google quer oferecer consultoria de Ética em IA

Hoje, há a preocupação de que softwares de Inteligência Artificial venham sendo usados para a postagem de Fake News em redes sociais (o caso foi um estudo, já avisando), com o intuito de ludibriar o usuário comum, mas e quanto a especialistas? Pois um estudo recente mostrou que eles também podem ser enganados por IAs em seus campos de atuação.

A pesquisa foi conduzida por um time de profissionais do departamento de Ciência da Computação e Engenharia Elétrica da Universidade de Maryland, nos Estados Unidos. O software usado foi novamente o GPT-3 (Generative Pre-trained Transformer-3), desenvolvido pela OpenAI, um grupo voltado ao desenvolvimento de IAs amigáveis, fundado em 2015 por Elon Musk, Greg Brockman, ex-CTO da Stripe, e Sam Altman, presidente da aceleradora Y Combinator.

A OpenAi é uma adversária direta do DeepMind e outras companhias similares, e em 2019, a empresa recebeu um aporte de US$ 1 bilhão da Microsoft para tocar seus projetos. Além desta e de Musk, a joint conta também com investimentos de outros membros da "máfia do PayPal", como Peter Thiel e Reid Hoffman, e também da Y Combinator, via Altman e Jessica Livingston.

Os softwares da família GPT são modelos generativos de linguagem, desenvolvidos para compor sentenças de texto complexas e providas de contexto. O software em si é capaz de identificar uma palavra, analisar o início da frase e prever qual a próxima mais adequada a ser inserida, dependendo do tipo de texto que foi programado para "escrever". Demonstrações foram feitas no passado, ao alimentar a IA com trechos pré-escritos originais, ou de obras conhecidas, e o software foi capaz de dar sequência, no mesmo estilo literário.

Na época, a OpenAi decidiu não divulgar o resultado do GPT-2 publicamente, dado que a qualidade de suas criações era suficientemente apurada para redigir notas simples, como postagens falsas em redes sociais, o que acabou acontecendo através de outros players no mercado. O GPT-3, a atual geração do sistema especialista, é fornecido de forma limitada a empresas e startup parceiras, mas mesmo estas não escaparam do fator humano, como o game AI Dungeon demonstrou.

Ainda assim, a maioria dos casos de IAs usadas para o mal visam ludibriar pessoas comuns, que são mais fáceis de serem manipuladas, mas seria possível passar a perna em um profissional qualificado, com uma Fake News dentro de seu campo de atuação? Pois o estudo de Maryland descobriu que sim.

Sistemas e IAs vêm sendo usados para identificar postagens falsas, desde a OpenAi com o próprio GPT-3, a um conjunto de modelos chamado Transformers, este empregado pelo Google para refinar seus algoritmos, junto com o proprietário BERT da gigante das buscas, usado para entender linguagem natural.

O Transformers, no caso, foi a ferramenta usada pelos pesquisadores para criar relatórios falsos, com linguagem acadêmica, a fim de enganar profissionais de cibersegurança e de medicina. Em um deles, foi criada uma sentença baseada numa entrada sobre uma vulnerabilidade real, em que o modelo criou um texto completo, com termos comuns à área de TI, mas com impressões totalmente falsas.

O texto foi enviado a profissionais da área de detecção e combate a ameaças à Segurança da Informação, e de maneira surpreendente, eles não foram capazes de apontar que a entrada era um texto falso, gerado por uma IA se baseando em uma informação inicial verdadeira, mas tendo inventado todo o resto.

Da mesma forma, o Transformers foi capaz de criar um texto usando informações básicas sobre o SARS-CoV-2, vírus causador da COVID-19, e segundo o time de pesquisadores, a ferramenta poderia ser usada para a publicação de um artigo científico falso completo, que acabaria sendo publicado em periódicos e usado na tomada de decisões na linha de frente.

Se levarmos em conta os estudos enviesados que a princípio endossavam o uso de remédios ineficazes, que com o devido escrutínio como confirmados como infundados, o mesmo tipo de estrago pode ser causado por uma publicação falsa produzida por um sistema especialista, usando termos-chave para elaborar o texto restante.

Em ambos os casos, textos falsos gerados por IA podem ser identificados como tais por outros sistemas especialistas, mas o perigo está na capacidade desses algoritmos serem capazes de passar como factíveis pela primeira linha, que é a avaliação humana por profissionais, versados em linguagens de seus campos de atuação, que uma máquina já consegue emular com certo grau de precisão, o bastante para enganar.

Claro que se tratam de estudos isolados, mas é muito provável que no futuro, grupos poderão usar IAs e sistemas especialistas para criar textos e artigos mirando criar ruído ou validar pontos controversos em publicações científicas (claro que humanos já publicaram muita coisa ruim ao longo dos anos), e neste caso, cabem a empresas e profissionais aprimorarem seus métodos de detecção. E claro, os profissionais precisam ficar bem mais atentos com o que leem por aí.

Fonte: The Conversation