Google DeepMind será utilizado para diagnosticar doenças oculares

Depois de arrasar no Go, Google DeepMind usará algoritmos de aprendizado de máquina para diagnosticar doenças oculares em seus estágios iniciais

Ronaldo Gogoni 8 anos atrás

O Google DeepMind, laboratório britânico de pesquisa especializado em inteligência artificial começa finalmente a voltar sua atenção para outras coisas que não sejam jogos, sejam de videogame ou milenares. A subsidiária do Google que recentemente fez história com o AlphaGo, um algoritmo capaz de cenver um dos maiores jogadores do mundo fechou uma parceria com o Serviço Nacional de Saúde do Reino Unido (National Health Service, ou NHS) para desenvolver novos algoritmos capazes de diagnosticar doenças oculares em seus estágios iniciais, o que pode evitar que muita gente acabe perdendo a visão.

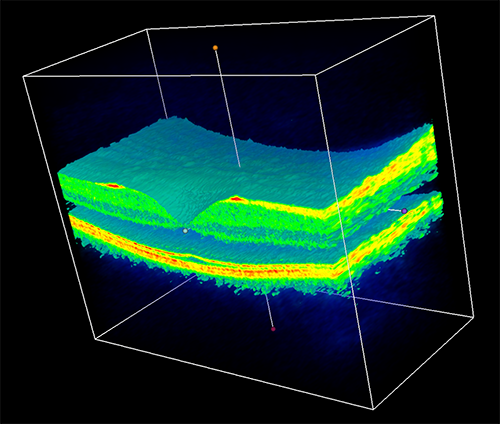

O objetivo do NHS é combater os casos de cegueira que evoluem a partir de doenças que podem ser tratadas se diagnosticadas a tempo, bem como identificar outros problemas como catarata e glaucoma. A ideia é treinar os algoritmos do DeepMind de modo que ele seja capaz de identificar quaisquer problemas nos olhos do paciente com um simples escaneamento de retina. Para isso o departamento irá fornecer ao Google DeepMind cerca de um milhão de scans oculares anônimos, assim uma rede neural através de aprendizado de máquina terá um extenso banco de dados à sua disposição.

O projeto surgiu após um oftalmologista ler sobre a pesquisa do DeepMind com os jogos do Atari 2600; este contatou o Google levantando a possibilidade de que se os algoritmos desenvolvidos pela eram tão bons a ponto de aprender a jogar videogame, poderiam também ser treinados para identificar doenças nos olhos analizando registros de exames passados.

Esta não é nem sequer a primeira parceria entre o Google e o NHS, quando o DeepMind Health foi introduzido em fevereiro ambos anunciaram como primeiro projeto uma pesquisa com foco em doenças dos rins, neste caso voltado para monitoramento de pacientes através de apps móveis.

No entanto, a nova pesquisa se foca em prevenção e não tratamento. Quanto mais cedo doenças oculares são diagnosticadas, mais eficiente é o tratamento e menores são as chances do paciente acabar cego ou com a visão severamente reduzida.

DeepMind Health – Moorfields Eye Hospital London Collaboration

Há quem acredite que a IA vai nos exterminar a longo prazo, mas é bem possível que num primeiro momento ela nos ajude a viver mais e melhor. E nós agradecemos.

Fonte: Google.