GTC 2017 — nVidia Tesla V100, com a super GPU da arquitetura Volta dedicada à IA

Na GTC 2017 a nVidia revelou a placa Tesla V100, processador gráfico com arquitetura Volta dedicado à softwares de inteligência artificial. O desempenho bruto dela equivale a 2,5× Project Scorpio (FP32).

Emanuel Laguna 7 anos atrás

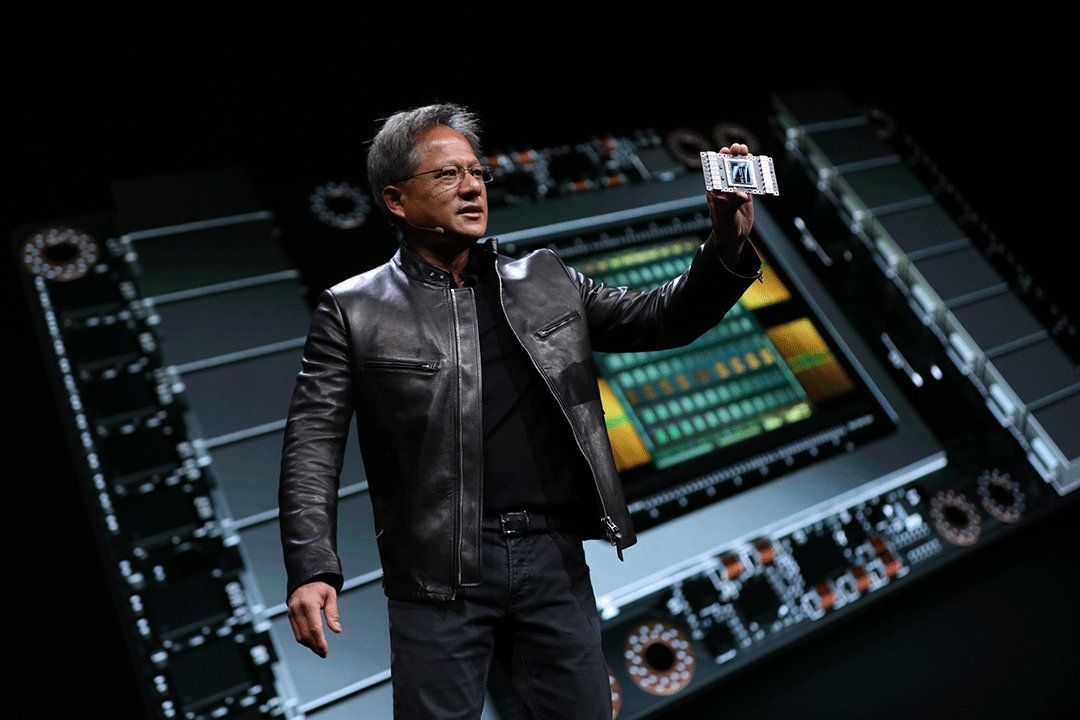

Se depender da nVidia, a inteligência artificial ficará cada vez mais esperta. Que o diga o CEO Jensen Huang ao apresentar a nova arquitetura de GPUs Volta para uma plateia de 7.000 cientistas e engenheiros na GPU Technology Conference — GTC 2017.

A microarquitetura Volta da nVidia consegue entregar 5× o desempenho da Kepler em FP64. O primeiro produto é o chip GV100, que primeiro equipará as placas de vídeo Tesla V100. Não, não terá uso imediato para jogos, embora uma demonstração do Kingsglaive: Final Fantasy XV tenha sido apresentada rodando nesse hardware. As placas gráficas Tesla servem para aplicações mais nobres, como softwares de inteligência artificial.

As placas com a GPU nVidia Tesla V100 serão voltadas à inteligência artificial (crédito: Anand Tech)

O chip Volta GV100 é o sucessor do Pascal GP100. Os processadores gráficos baseados na arquitetura Pascal eram litografados no processo FinFET de 16 nm, enquanto o chip GV100 inicia a produção de pastilhas de silício num processo de litografia que a TSMC chama de 12 nm FFN.

Na verdade, o que a TSMC fez foi melhorar a densidade de componentes da litografia de 16 nm e chamou esse processo de 12 nm FFN. Tem um tamanho muito próximo, mas não é uma litografia em 12 nm per se. GlobalFoundries, Intel e Samsung já têm seus próprios processos de litografia de 14 nm consolidados ou em algum estágio comercial mas cada uma dessas empresas concorrentes está a ter seus próprios desafios para conseguirem litografias ainda menores. Tem sido complicado avançar de facto nesse detalhe, então o melhor para a estratégia comercial foi mudar o nome.

Outra observação: enquanto as placas de vídeo voltadas para os consumidores usam memórias do tipo GDDR5X, nas placas gráficas Tesla a nVidia tem usado memórias do tipo HBM, mais caras. No caso das duas últimas gerações das Tesla, as memórias HBM2.

Ressalvas feitas, o que há de novo na microarquitetura Volta?

Bom, a nVidia introduziu oito dos chamados núcleos Tensor em cada um dos blocos de computação SM (Streaming Multiprocessor). Esses núcleos tensores adicionais serão responsáveis por cálculos dedicados de inteligência artificial, que normalmente eram feitos usando GPGPU ou mesmo delegados aos processadores centrais.

Com os núcleos Tensor o desempenho da arquitetura Volta em inteligência artificial conseguiu ser o quádruplo da arquitetura Pascal nesse tipo de software. As redes neurais agradecem. Quanto às outras melhorias, temos:

| Comparação das GPUs nVidia Tesla | |||

| GPU → | Tesla V100 | Tesla P100 | Tesla K40 |

| chip | GV100 | GP100 | GK110B |

| tamanho do chip | 815 mm² | 610 mm² | 551 mm² |

| número de transistores | 21 bilhões | 15,3 bilhões | 7,1 bilhões |

| blocos de computação | 80 SMs | 56 SMs | 15 SMs |

| núcleos CUDA | 5.120 | 3.584 | 2.880 |

| configuração | 112 ROPs / 320 TMUs | 96 ROPs / 224 TMUs | 48 ROPs / 240 TMUs |

| clock normal (modo Boost) | ?,?? GHz (1,45 GHz) | 1,33 GHz (1,53 GHz) | 745 MHz (875 MHz) |

| desempenho bruto (FP16) | 30 Tflop/s | 21,2 Tflop/s | 4,29 Tflop/s |

| desempenho bruto (FP32) | 15 Tflop/s | 10,6 Tflop/s | 4,29 Tflop/s |

| desempenho bruto (FP64) | 7,5 Tflop/s | 5,3 Tflop/s | 1,43 Tflop/s |

| VRAM | 16 GB HBM2 | 16 GB HBM2 | 12 GB GDDR5 |

| interface da memória | 4.096 bits | 4.096 bits | 384 bits |

| largura de banda da memória | 900 GB/s | 720 GB/s | 288 GB/s |

| TDP | 300 W | 300 W | 235 W |

| arquitetura | Volta | Pascal | Kepler |

| processo | TSMC 12 nm FFN | TSMC 16 nm FinFET | TSMC 28 nm |

| lançamento | final de 2017 | abril de 2016 | novembro de 2013 |

·

Bom lembrar que o chip GV100 completo possui 84 SMs (5.376 núcleos, 336 TMUs, etc) e estamos a falar do utilizado na placa Tesla V100. Provavelmente veremos o GV100 completo numa sucessora da Titan Xp daqui a um ou dois anos. Mesmo assim, os 15 teraflop/s significam um monstro de desempenho em FP32. São basicamente dois vírgula cinco Project Scorpio de desempenho gráfico bruto!

Tudo isso para a inteligência artificial, e para o Project Holodeck que permite softwares de realidade virtual multiusuários. O primeiro produto a ser lançado com a placa Tesla V100 será o servidor nVidia DGX-1V, que conterá 8 placas Tesla V100. O preço é competitivo no segmento, começando em “apenas” US$ 149.000 ou 485 mil reais na cotação de ontem (19/05).

A quem se interessar, assista à conferência da nVidia na GTC 2017 completa abaixo.

nVidia GPU Technology Conference 2017

Fontes: Anand Tech e nVidia Blog.